Desde la introducción del protocolo 802.11b, cada generación subsecuente de Wi-Fi ha traído consigo mayor velocidad y rendimiento para el usuario. Mientras transitamos el camino de la transformación digital, especialmente en la era de dispositivos y edge computing, el nuevo estándar se enfrenta con diferentes desafíos para poder satisfacer la demanda del usuario. En mayo de 2013, el Grupo de Estudio WLAN de Alta Eficiencia, del grupo de trabajo IEEE 802.11, comenzó a considerar el perfeccionamiento de la eficiencia del espectro para mejorar el rendimiento en escenarios de alta densidad en puntos de acceso/usuarios y así es como comenzó el proyecto 802.11ax, también conocido como Wi-Fi 6, en mayo de 2014.

Osama Aboul Magd fue elegido para liderar el grupo de trabajo IEEE 802.11ax WLAN. Entrevistado para conocer lo último en estándares Wi-Fi, sus implicaciones y diversos casos relevantes para el nuevo estándar, Aboul Magd explicó por qué hubo un cambio de nombre, así como por qué los usuarios y clientes deberían considerar Wi-Fi 6, si es que no lo están planeando ya. Como explicó Osama, “Wi-Fi 6 es esencial para transformar la manera en que soportamos las aplicaciones en las redes Wi-Fi de hoy. Su implementación permite una nueva y mejorada experiencia de usuario en escenarios de implementación densos, en comparación con las generaciones anteriores de Wi-Fi”.

Osama Aboul Magd fue elegido para liderar el grupo de trabajo IEEE 802.11ax WLAN. Entrevistado para conocer lo último en estándares Wi-Fi, sus implicaciones y diversos casos relevantes para el nuevo estándar, Aboul Magd explicó por qué hubo un cambio de nombre, así como por qué los usuarios y clientes deberían considerar Wi-Fi 6, si es que no lo están planeando ya. Como explicó Osama, “Wi-Fi 6 es esencial para transformar la manera en que soportamos las aplicaciones en las redes Wi-Fi de hoy. Su implementación permite una nueva y mejorada experiencia de usuario en escenarios de implementación densos, en comparación con las generaciones anteriores de Wi-Fi”.

Uno de los objetivos del estándar 802.11ax era tener una mejor experiencia de usuario e incrementar el rendimiento en un factor de cuatro o más para clientes de red individuales. Se esperaba que el estándar mejorara el rendimiento de Wi-Fi en entornos densos, con un gran número de usuarios, como lugares públicos, usando el espectro disponible de manera más eficiente, controlando la interferencia y realizando mejoras a protocolos como el Control de Acceso Medio (MAC). Asimismo, la idea era comenzar a usar OFDMA, un estándar que ya se usaba en LTE y en los estándares de Wi-Fi anteriores. Esto eventualmente ayudaría a contener más datos en un mismo espacio aéreo.

Dado que los nombres para estándares Wi-Fi son un poco complicados, se decidió a fines del año pasado utilizar términos más sencillos de pronunciar. En resumen, el nuevo estándar 802.11ax se llamará Wi-Fi 6, mientras que las dos generaciones anteriores de tecnología Wi-Fi se llamarán Wi-Fi 4 (para 802.11n) y Wi-Fi 5 (para 802.11 A.C).

El cambio de nombre también destaca el hecho de que 802.11ax es, de hecho, la sexta generación de tecnología de redes Wi-Fi, muy apropiado desde el punto de vista numérico. Desde el punto de vista visual, los usuarios podrían observar en sus teléfonos inteligentes los números junto al ícono de Wi-Fi y confirmar si es Wi-Fi 4, Wi-Fi 5, o Wi-Fi 6, ayudando a simplificar los protocolos que se están utilizando.

El cambio de nombre también destaca el hecho de que 802.11ax es, de hecho, la sexta generación de tecnología de redes Wi-Fi, muy apropiado desde el punto de vista numérico. Desde el punto de vista visual, los usuarios podrían observar en sus teléfonos inteligentes los números junto al ícono de Wi-Fi y confirmar si es Wi-Fi 4, Wi-Fi 5, o Wi-Fi 6, ayudando a simplificar los protocolos que se están utilizando.

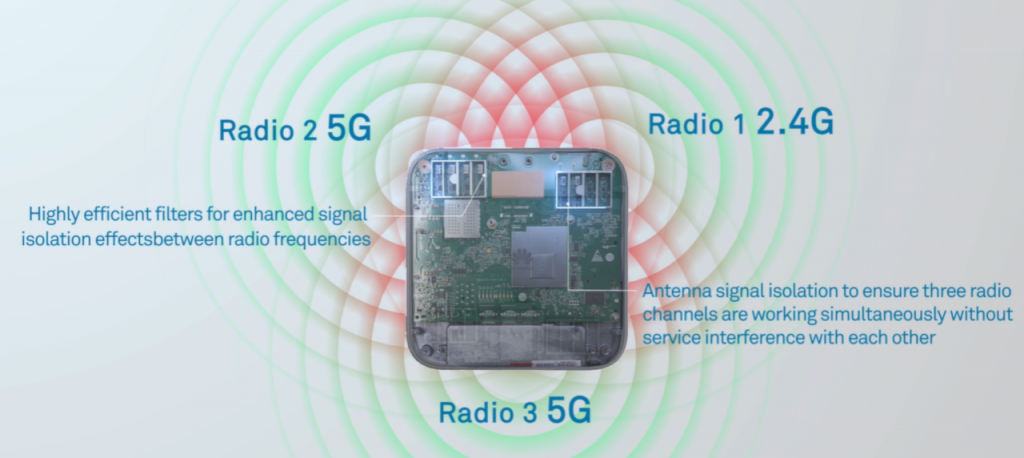

Además, desde el punto de vista tecnológico, el Wi-Fi 6 no es simplemente una mejora de rendimiento para el Wi-Fi 5, sino que el Wi-Fi 6 hace algunos cambios fundamentales al estándar, incluida una amplia gama de capas físicas (PHY) y características de la capa de control de acceso medio (MAC), complementadas con MIMO multiusuario y reutilización especial. Wi-Fi 6 agrega una mejora significativa al admitir hasta ocho flujos espaciales. El estándar Wi-Fi 6 amplía el rango de formación de haz (beamforming), permitiendo a más usuarios conectarse a los puntos de acceso de manera simultánea sin dejar de ofrecer un alto rendimiento.

Uno de los principales usos de Wi-Fi 6 se da en entornos densos donde hay una gran cantidad de usuarios como estadios, centros comerciales, aeropuertos, auditorios o aulas. Wi-Fi 6 es realmente útil cuando los usuarios utilizan aplicaciones de uso intensivo de ancho de banda, o aplicaciones sensibles a la latencia. No sólo aumenta el rendimiento, sino que los avances tecnológicos en Wi-Fi 6 permiten una experiencia de usuario superior para el rendimiento de la aplicación, ya sea aprendizaje en tiempo real, o en aplicaciones de realidad aumentada y realidad virtual. Las aplicaciones del IOT (Internet de las Cosas) tendrán una mejora adicional mediante el uso de Wi-Fi 6, dadas las funciones como Target Wait Time (TWT), que ayuyda a reducir el consumo de energía y a conservar la vida útil de la batería.

En entornos universitarios con más de 30 mil estudiantes, o en estadios deportivos al aire libre con 80 mil personas, todos intentando conectarse al Wi-Fi al mismo tiempo, fácilmente podrían provocar una congestión con Wi-Fi 5, pero Wi-Fi 6 resuelve este problema, ya que permite a más usuarios conectarse a un solo punto de acceso (AP) simultáneamente, y permite que los dispositivos vecinos transmitan al mismo tiempo, siempre y cuando los niveles de interferencia sean aceptables. De hecho, para la misma cantidad de usuarios y área de cobertura, la cantidad de puntos de acceso requeridos para Wi-Fi 6 es significativamente menor en comparación con los estándares anteriores, lo que lleva a ahorros sustanciales en gastos de capital. Wi-Fi 6 también se convierte en un habilitador de muchas nuevas aplicaciones y no solo las existentes, especialmente de videos UHD y 4K.

Según Osama, compañías como Huawei han desempeñado un papel clave en el desarrollo del protocolo y el estándar de Wi-Fi 6. Además de encabezar el grupo de trabajo, Huawei proporcionó casi el 25% de las contribuciones presentadas al grupo técnico. La mayoría de estas presentaciones fueron adoptadas en el documento estándar. Huawei ha sido uno de los primeros en adoptar Wi-Fi 6 al lanzar su prototipo en 2014 y al desplegar su AP en 2017.

En cuanto a la adquisición, ahora es un buen momento para comenzar a planear el Wi-Fi 6. Observando su estrategia de transformación digital y cómo va a afectar en la infraestructura de TI, los directores y gerentes de TI deben comenzar a pensar en el Wi-Fi 6 para facilitar el proceso de migración. Muchos de los fabricantes de hardware y proveedores de chips ya han producido chips para Wi-Fi 6 y aseguran la interoperabilidad entre ellos. Esperamos que 2019 sea el año de adopción de Wi-Fi 6, ya que muchas organizaciones comienzan a evaluar su estrategia de Wi-Fi a largo plazo a raíz de los nuevos desafíos de la digitalización.

Fuente: Forbes