l gato de Schrödinger es el gato más famoso de la Historia de la Ciencia por una curiosa característica: metido dentro de su caja puede estar vivo y muerto al mismo tiempo. No vivo o muerto, sino vivo y muerto a la vez. Su estado solo se determina cuando alguien abre la tapa y mira dentro. Entonces encontrará al gato tieso o maullando.

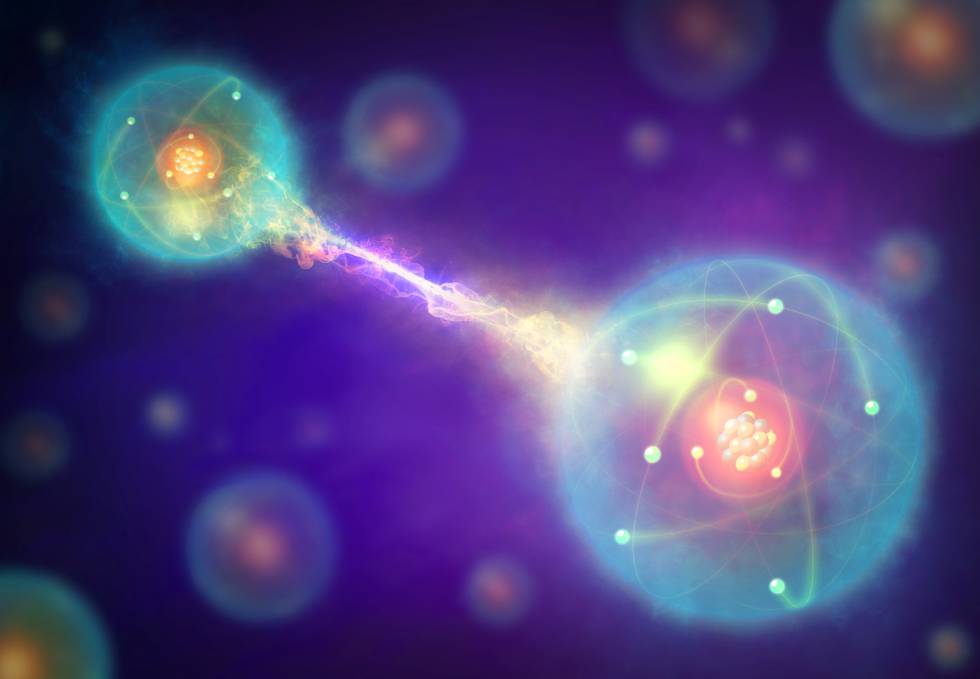

Con esta metáfora se pretende visibilizar una de las características de la mecánica cuántica: los objetos cuánticos, que viven en el mundo subatómico (los gatos, por tanto, no lo son), pueden estar en varios estados a la vez. Por ejemplo, un electrón puede estar en una superposición de dos estados de spin a la vez (grosso modo, como si rotase en ambos sentidos al mismo tiempo). Sí, es difícil de entender para la mente humana.

“Basándose en características de la naturaleza del mundo microscópico como esta, la computación cuántica (CC) pretende hacer cálculos y fabricar ordenadores más rápidos y eficientes”, dice Francisco Gálvez experto de larga trayectoria en IBM dedicado a la difusión de la CC que ahora afronta otros proyectos.

- ¿Cómo se computa?

Antes de entender la computación cuántica es preciso entender la computación clásica. Los ordenadores normales, como los que usamos usted y yo, funcionan a base de los dígitos 0 y 1 (de ahí el popular término digital). Estos 0 y 1 abstractos, llamados bits, en el mundo físico se encarnan en pequeñas corrientes eléctricas que representan el 0 y el 1 y cuyos interruptores son unos ingenios llamados transistores, fundamentales para la tecnología. En un chip de silicio hay miles de millones de transistores diminutos. Con esas diminutas corrientes eléctricas se hacen millones de operaciones matemáticas por segundo (de ahí los gigahertzios de los procesadores). Cuando usted juega a un videojuego o escribe en un procesador de texto o pierde el tiempo en una red social, lo que hay detrás, en el fondo, son estos millones y millones de operaciones matemáticas ultrarrápidas. He aquí el prodigio de la informática.

Se puede trazar alguna analogía entre la historia de la computación clásica y la cuántica. “Este es un momento dulce para la CC”, dice Miguel Ángel Martín-Delgado, catedrático de Física Teórica de la Universidad Complutense de Madrid (UCM). “Es como si estuviéramos en el garaje con Steve Jobs, no se daban cuenta de que se estaba produciendo una revolución con ese tipo ordenadores de garaje. En ese momento de ebullición estamos ahora con los ordenadores cuánticos”.

- Los qubits

La novedad con la computación cuántica es que, en vez de usar transistores que puedan generar estados 0 o 1, utiliza los llamados qubits (bits cuánticos), que no solo están en 0 o 1 sino en una superposición de ambos estados, como el gato de Schrödinger, muerto y vivo a la vez. Esta superposición de estados posibilita una capacidad de computación exponencialmente mayor, ordenadores más rápidos y eficientes. Eso sí, mientas nadie “mire” a los qubits, mientas nadie abra la caja del gato.

Para realizar los qubits físicamente se utilizan ciertos dispositivos, igual que los ordenadores clásicos han usado relés, bombas de vacío y, ahora, millones de pequeños transistores. La base palpable de un ordenador cuántico puede ser de varios tipos. Por ejemplo, las trampas de iones, que toman átomos a los que le faltan uno o varios electrones (los iones) y los hacen interaccionar con láseres, o los anillos superconductores a temperaturas cercanas al cero absoluto. Esta última es la tecnología más utilizada en la actualidad. Cualquiera de estos ingenios puede simular un qubit en superposición de varios estados.

La Ley de Moore sobre el crecimiento exponencial de la computación llega a su fin al alcanzarse los límites de la naturaleza”

La ventaja de los qubits es que, gracias a propiedades como la superposición y el entrelazamiento cuántico (cuando se opera con dos o más de ellos), pueden realizar muchas más operaciones al mismo tiempo que los bits clásicos. Y ese número de operaciones crece de manera exponencial (2 elevado a n) con el número (n) de qubits. Con un qubit se pueden hacer dos operaciones a la vez. Con dos qubits, cuatro operaciones. Con 10 qubits, 1024 operaciones al mismo tiempo. Con 15 qubits, 32.768 operaciones… Con esta potencia de cálculo problemas antes considerados difíciles de procesar se hacen fácilmente resolubles.

Las dificultades que aparecen en el camino hacia la computación cuántica no son fáciles de sortear. Las principales tienen que ver con la sensibilidad de los qubits a las perturbaciones y al ruido. “Son el problema de la decoherencia, que es la destrucción de los estados cuánticos por interacción con el entorno, y el de la precisión: ahora mismo la precisión de un ordenador cuántico puede ser de un 99,3%”, dice Juan José García Ripoll, investigador del Instituto de Física Fundamental del Consejo Superior de Investigaciones Científicas (CSIC).

“Nobody is perfect”, dice el catedrático Martín-Delgado, parte de cuyo trabajo en el Grupo de Información y Computación Cuánticas de la UCM consiste en acabar con los errores de los ordenadores cuánticos. “Estos errores tienen su fuente en el ambiente, los qubits se acoplan al exterior, a campos magnéticos o eléctricos, a efectos térmicos. Luego cuando quieres hacer una operación lógica no sale perfecta”, explica. El ambiente actúa como el observador del gato Schrödinger, destruye la superposición de estados cuánticos. Los qubits prefieren trabajar aislados, lejos de la mirada del mundo: de otra manera se ponen en huelga. Además, cuantos más qubits hay en un ordenador, más fácilmente puede producirse la decoherencia, cada vez es más difícil hacerlos trabajar juntos sin romper el delicado “silencio” que necesitan.

- ¿Para qué sirve?

¿Para qué serviría (o sirve) la computación cuántica? Por el momento es de utilidad en criptografía y se puede usar para cálculos químicos, diseños de nuevos materiales o para buscar con rapidez en grandes bases de datos no indexadas. Puede ayudar al machine learning y al desarrollo de la inteligencia artificial. No conocemos todo su potencial: al comienzo de la informática clásica, cuando el ordenador ENIAC ocupaba una habitación entera, solo se utilizaba para complejos cálculos de balística militar u otros grandes cálculos industriales y nadie si imaginaba el sin fin de aplicaciones que la informática llegaría a ofrecer al ciudadano de a pie. O que cada ciudadano tendría un smartphone en su mano como una prolongación de su cuerpo.

“La computación cuántica lleva unos veinte años cocinándose”, explica Ignacio Cirac, el investigador español del Instituto Max Plack. La investigación se inició en las universidades y centros de investigación: en ellos se consiguió construir los primeros prototipos, que han ido evolucionando hasta llegar a los 10 qubits). “Lo que ha cambiado hace un par de años”, continúa Cirac, “es que grandes empresas tecnológicas han anunciado que van a dedicar grandes esfuerzos a construir ordenadores cuánticos más potentes”. Google, IBM, Intel o Microsoft entre otras, invierten ahora no pocos esfuerzos y compiten por desarrollar esta tecnología.

Por el momento han construido prototipos mayores (de hasta más de 50 qubits), todavía imperfectos. Por tanto, en palabras de Cirac, “los retos que se presentan son: primero, mejorar los prototipos actuales para que tengan menos errores; segundo, desarrollar aplicaciones para estos prototipos; y tercero, a mucho más largo plazo, construir ordenadores mucho mayores (de millones de qubits) en donde no se produzcan errores (o se puedan corregir)”.

Existen varios tipos de ordenadores cuánticos. “Algunos, llamados optimizadores, resuelven solo problemas de optimización”, dice García Ripoll. Por ejemplo, en el optimizador D-wave (también llamado computador adiabático) “se reformula el problema como la energía de un sistema físico y se buscan sus mínimos, arrojando así soluciones al problema”, dice el científico. Así, la empresa Volkswagen ya trabaja con D-Wave para optimizar rutas de coches en lugares como Beijing y luchar contra los atascos.

Luego están los ordenadores propiamente dichos, porque pueden ser programados para resolver cualquier problema. Como la máquina que imaginó Alan Turing y que define lo que es un ordenador. Son los que tratan de desarrollar las grandes empresas antes citadas.

- ¿Quién vencerá?

El término supremacía cuántica es rechazado por muchos científicos por sus feas connotaciones, y tratan de cambiarlo por uno más amable y preciso: la ventaja cuántica. Esta se dará cuando un ordenador cuántico consiga resolver el mismo problema que un ordenador clásico (uno de los potentes supercomputadores) en un tiempo menor. El momento, según confían los expertos, está cerca. En Google aseguran tenerlo al alcance de los dedos con su procesador cuántico Bristlecone. Tal hecho significará un punto de inflexión en la historia de la tecnología.

La CC, además, es un paso necesario para el progreso tecnológico: la miniaturización está llegando a su fin, porque los transistores de los ordenadores clásicos ya son demasiado pequeños: Intel ya los construye de solo 10 nanómetros. Es un ingenio muy pequeño: un átomo mide algo menos de un nanómetro. Y no se puede construir un transistor más pequeño que un átomo, que es el ladrillo del que están hechas las cosas. El límite está cerca. “Además, a esas escalas nanométricas pueden aparecen efectos cuánticos no deseados que hagan fallar el funcionamiento de los chips”, confirma el catedrático Martín-Delgado. La famosa Ley (empírica) de Moore, que dice que la potencia de los ordenadores crece de forma exponencial, doblándose cada 18 meses, llega a su fin por darse con los propios límites que pone la naturaleza. El camino natural a seguir es el de la computación cuántica.

¿Significará la llegada de los ordenadores cuánticos la desaparición de los computadores clásicos? “No”, explica Martín-Delgado, “en realidad ambos tipos de computación siempre van a convivir. Para tratar los datos que arroje un ordenador cuántico siempre será necesario un computador clásico. Tampoco va a acabar con la creatividad humana: cuando obtienes un dato tendrás que seguir pensando para ver qué es lo que has obtenido”.

Fuente: Retina El Pais