Gran parte del progreso reciente en IA proviene de la construcción de redes neuronales cada vez más grandes. Un nuevo chip lo suficientemente potente como para manejar modelos a “escala cerebral” podría impulsar este enfoque.

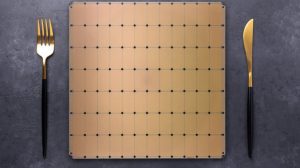

La startup de chips Cerebras saltó al centro de atención en 2019 cuando salió sigilosamente para revelar un chip de transistor de 1,2 billones. El tamaño de un plato llano, el chip se llama Wafer Scale Engine y era el chip de computadora más grande del mundo . A principios de este año, Cerebras presentó el Wafer Scale Engine 2 ( WSE-2 ), que duplicó con creces el número de transistores a 2,6 billones.

Ahora, la compañía ha esbozado una serie de innovaciones que significan que su último chip puede entrenar una red neuronal con hasta 120 billones de parámetros. Como referencia, el revolucionario modelo de lenguaje GPT-3 de OpenAI contiene 175 mil millones de parámetros . T él la mayor red neuronal hasta la fecha , que fue entrenado por Google, tenía 1,6 billones.

“ Las redes más grandes, como GPT-3, ya han transformado el panorama del procesamiento del lenguaje natural, haciendo posible lo que antes era inimaginable”, dijo el CEO y cofundador de Cerebras , Andrew Feldman, en un comunicado de prensa .

“ La industria está superando el billón de modelos de parámetros y estamos ampliando ese límite en dos órdenes de magnitud, lo que permite redes neuronales a escala cerebral con 120 billones de parámetros”.

La genialidad del enfoque de Cerebras es que, en lugar de tomar una oblea de silicio y dividirla para hacer cientos de chips más pequeños, hace s uno solo masivo. Si bien su GPU promedio tendrá unos cientos de núcleos, el WSE-2 tiene 850,000. B ebido a que están todos en el mismo trozo de silicio, que pueden trabajar juntos sin problemas mucho más.

Esto hace que el chip sea ideal para tareas que requieren una gran cantidad de operaciones en paralelo, lo que incluye tanto el aprendizaje profundo como varias aplicaciones de supercomputación. Y a principios de esta semana, en la conferencia Hotchips , la compañía dio a conocer una nueva tecnología que está impulsando aún más las capacidades del WSE-2.

Un desafío importante para las grandes redes neuronales es trasladar todos los datos involucrados en sus cálculos. La mayoría de los chips tienen una cantidad limitada de memoria en el chip, y cada vez que los datos tienen que ser mezclados, se crea un cuello de botella que limita el tamaño práctico de las redes.

El WSE-2 ya tiene una enorme cantidad de 40 gigabytes de memoria en chip, lo que significa que puede albergar incluso las redes más grandes de la actualidad . Pero la compañía también ha construido una unidad externa llamada MemoryX que proporciona hasta 2,4 Petabytes de memoria de alto rendimiento, que está tan estrechamente integrada que se comporta como si estuviera en un chip.

Cerebras también ha renovado su enfoque para que los datos que baraja alrededor. Anteriormente, las entrañas de la red neuronal se almacenaban en el chip y solo se introducían los datos de entrenamiento. Ahora, sin embargo, los pesos de las conexiones entre las neuronas de la red se guardan en la unidad MemoryX y se transmiten durante el entrenamiento.

Al combinar estas dos innovaciones, dice la compañía, pueden entrenar redes dos órdenes de magnitud más grandes que cualquier cosa que exista en la actualidad. Otros avances anunciados al mismo tiempo incluyen la capacidad de ejecutar redes neuronales extremadamente escasas ( y por lo tanto eficientes ) y un nuevo sistema de comunicación denominado SwarmX que permite vincular hasta 192 chips para crear un total combinado de 163 millones de núcleos.

No está claro cuánto costará toda esta tecnología de vanguardia y quién está en condiciones de aprovecharla. “Se trata de cosas muy especializadas”, dijo a Wired Mike Demler, analista senior de Linley Group . “Solo tiene sentido para entrenar a los modelos más grandes”.

Si bien el tamaño de los modelos de IA ha aumentado rápidamente, es probable que pasen años antes de que alguien pueda llevar el WSE-2 a sus límites. Y a pesar de las insinuaciones en el material de prensa de Cerebras, solo porque el recuento de parámetros coincide aproximadamente con el número de sinapsis en el cerebro, eso no significa que el nuevo chip podrá ejecutar modelos en cualquier lugar cercano a su complejidad o rendimiento.

Hay un gran debate en los círculos AI actual sobre si podemos lograr la inteligencia artificial en general por la simple construcción de redes neuronales más grandes, o esta se requieren nuevos avances teóricos. Hasta ahora, el aumento de los recuentos de parámetros ha dado lugar a saltos bastante consistentes en el rendimiento. Una mejora de dos de un orden de magnitud con respecto a los modelos más grandes de hoy en día sin duda, sería significativo.

Aún no está claro si esa tendencia se mantendrá, pero el nuevo chip de Cerebras podría acercarnos considerablemente a una respuesta.

Gent, E. (2021, 27 agosto). Cerebras Upgrades Trillion-Transistor Chip to Train «Brain-Scale» AI. Recuperado 27 de agosto de 2021, de https://singularityhub.com/2021/08/27/cerebras-upgrades-trillion-transistor-chip-to-train-brain-scale-ai/