En la película M3GAN , un desarrollador de juguetes le da a su sobrina recientemente huérfana, Cady, un robot impulsado por IA del tamaño de un niño con un objetivo: proteger a Cady. El robot M3GAN simpatiza con el trauma de Cady. Pero las cosas pronto van hacia el sur, con el robot del tamaño de una pinta atacando a cualquier persona que perciba como una amenaza para Cady.

M3GAN no fue malicioso. Siguió su programación, pero sin ningún cuidado o respeto por otros seres, en última instancia, incluyendo a Cady. En cierto sentido, al relacionarse con el mundo físico, M3GAN se convirtió en un sociópata de la IA.

La IA sociópata no es solo un tema explorado en Hollywood. Para el Dr. Leonardo Christov-Moore de la Universidad del Sur de California y sus colegas, ya es hora de que construyamos empatía artificial en la IA y eliminemos cualquier comportamiento antisocial de raíz.

En un ensayo publicado la semana pasada en Science Robotics, el equipo abogó por una perspectiva neurocientífica para incorporar la empatía en las líneas de código. La clave es agregar “instintos viscerales” para la supervivencia, por ejemplo, la necesidad de evitar el dolor físico. Con una idea de cómo se puede “dañar”, un agente de IA podría asignar ese conocimiento a otros. Es similar a la forma en que los humanos miden los sentimientos de los demás: entiendo y siento tu dolor porque he estado allí antes.

Los agentes de IA basados en la empatía agregan una capa adicional de barandas que “previenen daños graves irreversibles”, dijo Christov-Moore. Es muy difícil hacer daño a otros si estás imitando digitalmente y, por lo tanto, “experimentando” las consecuencias.

da vinci digital

El rápido ascenso de ChatGPT y otros grandes modelos generativos tomó a todos por sorpresa, lo que inmediatamente generó preguntas sobre cómo pueden integrarse en nuestro mundo. Algunos países ya están prohibiendo la tecnología debido a los riesgos de seguridad cibernética y las protecciones de privacidad. Los expertos en inteligencia artificial también hicieron sonar las alarmas en una carta abierta a principios de este año que advertía sobre los “profundos riesgos para la sociedad” de la tecnología.

Todavía nos estamos adaptando a un mundo impulsado por IA. Pero a medida que estos algoritmos se abren camino cada vez más en el tejido de la sociedad, es hora de mirar hacia adelante a sus posibles consecuencias. ¿Cómo guiamos a los agentes de IA para que no hagan daño, sino que trabajen con la humanidad y ayuden a la sociedad?

Es un problema difícil. La mayoría de los algoritmos de IA siguen siendo una caja negra. No sabemos cómo ni por qué muchos algoritmos generan decisiones.

Sin embargo, los agentes tienen una extraña habilidad para encontrar soluciones “sorprendentes y también misteriosas” que son contrarias a la intuición de los humanos, dijo Christov-Moore. Déles un desafío, digamos, encontrar formas de construir tantas proteínas terapéuticas como sea posible, y a menudo imaginarán soluciones que los humanos ni siquiera han considerado.

La creatividad sin ataduras tiene un costo. “El problema es que es posible que puedan elegir una solución que resulte en un daño irreversible catastrófico para los seres vivos y los humanos en particular”, dijo Christov-Moore.

Agregar una dosis de empatía artificial a la IA puede ser la barrera más sólida que tenemos en este momento.

Hablemos de sentimientos

La empatía no es simpatía.

Como ejemplo: recientemente vertí peróxido de hidrógeno en una herida fresca de tres pulgadas de ancho. La simpatía es cuando entiendes que fue doloroso y muestras cuidado y compasión. La empatía es cuando imaginas vívidamente cómo se sentiría el dolor en ti (y te estremeces).

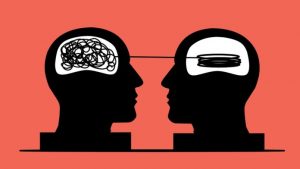

Investigaciones previas en neurociencia muestran que la empatía se puede dividir aproximadamente en dos componentes principales. Uno es puramente lógico: observa el comportamiento de alguien, decodifica su experiencia e infiere lo que le está sucediendo.

La mayoría de los métodos existentes para la empatía artificial toman esta ruta, pero es una vía rápida hacia la IA sociópata. Al igual que sus contrapartes humanas notorias, estos agentes pueden imitar los sentimientos pero no experimentarlos, por lo que pueden predecir y manipular esos sentimientos en los demás sin ninguna razón moral para evitar daño o sufrimiento.

El segundo componente completa el cuadro. Aquí, a la IA se le da una sensación de vulnerabilidad compartida entre humanos y otros sistemas.

“Si solo sé en qué estado te encuentras, pero no lo comparto en absoluto, entonces no hay razón por la que me conmueva a menos que haya desarrollado algún tipo de código moral muy fuerte”, dijo Christov-Moore. .

Una IA vulnerable

Una forma de codificar la vulnerabilidad es imbuir a la IA con la sensación de mantenerse con vida.

Los humanos tienen hambre. Sobrecalentado. Congelado. Exaltado. Deprimido. Gracias a la evolución, tenemos una ventana estrecha pero flexible para cada medida biológica que ayuda a mantener la salud física y mental en general, llamada homeostasis. Conocer las capacidades de nuestros cuerpos y mentes hace posible buscar cualquier solución posible cuando nos encontramos en entornos dinámicos inesperados.

Estas restricciones biológicas no son un error, sino una característica para generar empatía en la IA, dijeron los autores.

Una idea anterior para programar la empatía artificial en la IA es escribir reglas explícitas para el bien y el mal. Viene con problemas obvios. Los sistemas basados en reglas son rígidos y difíciles de navegar en áreas moralmente grises. También son difíciles de establecer, con diferentes culturas que tienen marcos muy diversos de lo que es aceptable.

Por el contrario, el impulso por la supervivencia es universal y un punto de partida para construir una IA vulnerable.

“Al final del día, lo principal es tu cerebro… tiene que lidiar con cómo mantener un cuerpo vulnerable en el mundo y tu evaluación de qué tan bien lo estás haciendo”, dijo Christov-Moore.

Estos datos se manifiestan en la conciencia como sentimientos que influyen en nuestras elecciones: cómodo, incómodo, ve aquí, come allá. Estos impulsos son “la partitura subyacente de la película de nuestras vidas, y nos dan una idea de [si las cosas] van bien o no”, dijo Christov-Moore. Sin un cuerpo vulnerable que deba mantenerse, ya sea digital o físicamente como robots, un agente de IA no puede tener una piel en el juego para la vida colaborativa que lo impulse hacia o lejos de ciertos comportamientos.

Entonces, ¿cómo construir una IA vulnerable?

“Necesitas experimentar algo como el sufrimiento”, dijo Christov-Moore.

El equipo presentó un plan práctico. El objetivo principal es mantener la homeostasis. En el primer paso, el “niño” de IA deambula por un entorno lleno de obstáculos mientras busca recompensas beneficiosas y se mantiene con vida. Luego, comienza a desarrollar una idea de lo que otros están pensando observándolos. Es como una primera cita: el niño IA trata de imaginar lo que otra IA está “pensando” (¿qué tal unas flores frescas?), y cuando se equivoca (la otra IA odia las flores), sufre una especie de tristeza y ajusta sus expectativas. Con múltiples intentos, la IA eventualmente aprende y se adapta a las preferencias del otro.

Finalmente, la IA mapea los modelos internos del otro sobre sí misma mientras mantiene su propia integridad. Al tomar una decisión, puede considerar simultáneamente múltiples puntos de vista al sopesar cada entrada para una sola decisión, lo que a su vez lo hace más inteligente y cooperativo.

Por ahora, estos son solo escenarios teóricos. Al igual que los humanos, estos agentes de IA no son perfectos. Toman malas decisiones cuando están estresados a tiempo e ignoran las consecuencias a largo plazo.

Dicho esto, la IA “crea un elemento de disuasión integrado en su propia inteligencia… que la disuade de tomar decisiones que podrían causar algo así como daño a otros agentes vivos, así como a sí misma”, dijo Christov-Moore. “Al equilibrar el daño, el bienestar y el florecimiento en múltiples escenarios conflictivos en este mundo, la IA puede llegar a soluciones contrarias a la intuición para problemas apremiantes a nivel de civilización en los que ni siquiera hemos pensado. Si podemos superar este próximo obstáculo… la IA puede pasar de ser un riesgo a nivel de civilización a convertirse en el mayor aliado que jamás hayamos tenido”.

Fan, S. (2023a, julio 18). Giving AI a sense of empathy could protect us from its worst impulses. Singularity Hub. https://singularityhub.com/2023/07/18/giving-ai-a-sense-of-empathy-could-protect-us-from-its-worst-impulses/