Un nuevo sistema del Laboratorio de Informática e Inteligencia Artificial del MIT trabaja analizando la luz en el borde de las paredes, que es impactada por los reflejos de objetos a la vuelta de la esquina de la cámara.

El uso de cámaras de teléfonos inteligentes, el sistema para ver las esquinas podría ayudar con auto-conducción de coches y de búsqueda y rescate.

La luz nos permite ver las cosas que nos rodean, pero ¿qué pasaría si también pudiéramos usarlo para ver cosas ocultas alrededor de las esquinas?

Suena como ciencia ficción, pero esa es la idea detrás de un nuevo algoritmo del Laboratorio de Informática e Inteligencia Artificial del MIT (CSAIL) – y su descubrimiento tiene implicaciones para todo, desde la respuesta de emergencia a los automóviles autodirigidos.

El sistema de imágenes del equipo CSAIL, que puede trabajar con cámaras de teléfonos inteligentes, utiliza información sobre reflejos de luz para detectar objetos o personas en una escena oculta y medir su velocidad y trayectoria, todo en tiempo real.

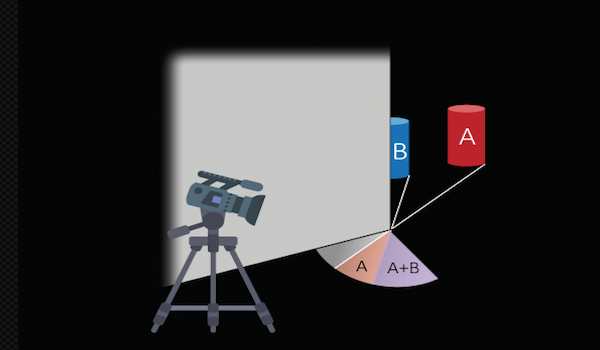

Para explicar, imagine que está caminando por un pasillo en forma de L y tiene una pared entre usted y algunos objetos a la vuelta de la esquina. Esos objetos reflejan una pequeña cantidad de luz en el suelo en su línea de visión, creando una sombra difusa que se conoce como la “penumbra”.

Usando el video de la penumbra, el sistema – que el equipo ha apodado “CornerCameras” – puede coser una serie de imágenes unidimensionales que revelan información sobre los objetos a la vuelta de la esquina.

“A pesar de que esos objetos no son realmente visibles para la cámara, podemos ver cómo sus movimientos afectan la penumbra para determinar dónde están y hacia dónde van”, dice Katherine Bouman SM ’13, PhD ’17, que es autor principal en un nuevo artículo sobre el sistema. “De esta manera, mostramos que las paredes y otras obstrucciones con bordes pueden ser explotadas como” cámaras “naturales que revelan las escenas ocultas más allá de ellas.

Bouman dice que la capacidad de ver alrededor de las obstrucciones sería útil para muchas tareas, desde los bomberos que encuentran a la gente en los edificios en llamas hasta los conductores que detectan a los peatones en sus puntos ciegos.

Ella co-escribió el artículo con los profesores del MIT Bill Freeman, Antonio Torralba, Greg Wornell y Fredo Durand; estudiante de maestría Vickie Ye; y el estudiante de doctorado Adam Yedidia. Ella presentará el trabajo a finales de este mes en la Conferencia Internacional sobre Visión por Computador en Venecia, Italia.

Cómo funciona

La mayoría de los acercamientos para ver alrededor de obstáculos implican lasers especiales. Específicamente, los investigadores brillan las cámaras en puntos específicos que son visibles tanto a la escena observable como ocultos, y luego miden cuánto tiempo toma para que la luz regrese.

Sin embargo, estas llamadas ” cámaras de tiempo de vuelo ” son caras y fácilmente pueden ser tiradas por la luz ambiental, especialmente al aire libre.

Por el contrario, la técnica del equipo CSAIL no requiere activamente la proyección de luz en el espacio, y funciona en una amplia gama de entornos de interior y exterior y con cámaras de consumo disponibles.

Desde la visualización de video de la penumbra, CornerCameras genera imágenes unidimensionales de la escena oculta . Una sola imagen no es particularmente útil, ya que contiene una buena cantidad de datos “ruidosos”. Pero observando la escena a lo largo de varios segundos y cosiendo docenas de imágenes distintas, el sistema puede distinguir objetos distintos en movimiento y determinar su velocidad y trayectoria.

“La idea de intentar lograr esto es innovadora por sí misma, pero conseguir que funcione en la práctica demuestra creatividad y adeptness”, dice el profesor Marc Christensen, que sirve como decano de la Lyle School of Engineering en Southern Methodist University y no participó en la investigación. “Este trabajo es un paso significativo en el intento más amplio de desarrollar capacidades revolucionarias de formación de imágenes que no se limitan a la observación de la línea de visión”.

El equipo se sorprendió al descubrir que CornerCameras trabajó en una serie de situaciones difíciles, incluyendo condiciones climáticas como la lluvia.

“Dado que la lluvia estaba literalmente cambiando el color de la tierra, pensé que no había manera de que pudiéramos ver diferencias sutiles en la luz en el orden de un décimo de un por ciento”, dice Bouman. “Pero debido a que el sistema integra tanta información a través de docenas de imágenes, el efecto de las gotas de lluvia promedia, y así se puede ver el movimiento de los objetos, incluso en medio de toda esa actividad”.

El sistema todavía tiene algunas limitaciones. Por razones obvias, no funciona si no hay luz en la escena, y puede tener problemas si hay poca luz en la escena oculta en sí. También puede tropezar si las condiciones de luz cambian, como si la escena está al aire libre y las nubes se mueven constantemente a través del sol. Con las cámaras de calidad smartphone la señal también se debilita a medida que se aleja de la esquina.

Los investigadores planean abordar algunos de estos desafíos en futuros trabajos, y también tratarán de conseguir que funcione mientras están en movimiento. El equipo pronto lo probará en una silla de ruedas, con el objetivo de adaptarlo eventualmente para automóviles y otros vehículos.

“Si un niño salta a la calle, un conductor puede no ser capaz de reaccionar a tiempo”, dice Bouman. “Aunque todavía no estamos allí, una tecnología como esta podría ser utilizada un día para dar a los conductores unos segundos de tiempo de advertencia y ayudar en muchas situaciones de vida o muerte”.

Este trabajo fue apoyado, en parte, por el Programa DARPA REVEAL, la Fundación Nacional de Ciencias, Shell Research, y una beca de postgrado de Ciencias e Ingeniería de Defensa Nacional.

Fuente: MIT