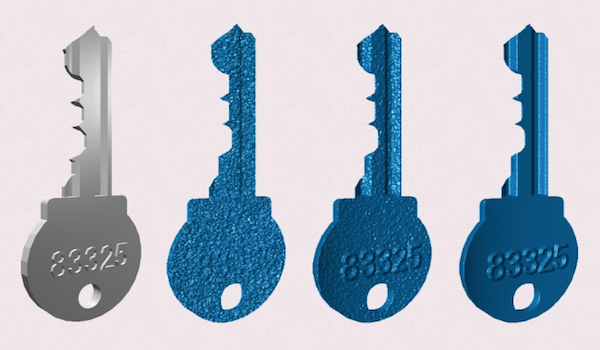

Comparación del enfoque de GHz en cascada con enfoques de estilo Kinect representados visualmente en una clave. De izquierda a derecha, la imagen original, un enfoque de estilo Kinect, un enfoque de GHz y un enfoque de GHz más fuerte.El método computacional mejora la resolución de los sensores de profundidad de tiempo de vuelo 1.000 veces.

Durante los últimos 10 años, el grupo Camera Culture del Media Lab del MIT ha desarrollado sistemas de imágenes innovadores, desde una cámara que puede ver alrededor de las esquinas hasta una que puede leer texto en libros cerrados , utilizando el “tiempo de vuelo”, un enfoque que mide la distancia midiendo el tiempo que tarda la luz proyectada en una escena para rebotar en un sensor.

En un nuevo documento que aparece en IEEE Access , los miembros del grupo Camera Culture presentan un nuevo enfoque para las imágenes de tiempo de vuelo que aumenta su resolución en profundidad 1.000 veces. Ese es el tipo de resolución que podría hacer que los autos autónomos sean prácticos.

El nuevo enfoque también podría permitir mediciones de distancia precisas a través de la niebla, lo que ha demostrado ser un obstáculo importante para el desarrollo de automóviles sin conductor.

En un rango de 2 metros, los sistemas existentes de tiempo de vuelo tienen una resolución de profundidad de alrededor de un centímetro. Eso es lo suficientemente bueno para los sistemas de estacionamiento asistido y detección de colisión en los automóviles de hoy.

Pero como Achuta Kadambi, estudiante de doctorado conjunto en ingeniería eléctrica y ciencias de la computación y artes y ciencias de los medios, y primer autor del artículo, explica: “A medida que aumenta el alcance, su resolución disminuye exponencialmente. Supongamos que tiene un escenario de largo alcance y desea que su auto detecte un objeto más lejano para que pueda tomar una decisión rápida de actualización. Es posible que haya empezado a 1 centímetro, pero ahora está de vuelta a [una resolución de] un pie o incluso 5 pies. Y si comete un error, podría llevar a la pérdida de la vida “.

A distancias de 2 metros, el sistema de los investigadores del MIT, por el contrario, tiene una resolución de profundidad de 3 micrómetros. Kadambi también llevó a cabo pruebas en las que envió una señal de luz a través de 500 metros de fibra óptica con filtros regularmente espaciados a lo largo de su longitud, para simular la caída de energía en distancias más largas, antes de alimentarlo a su sistema. Esas pruebas sugieren que en un rango de 500 metros, el sistema MIT aún debe lograr una resolución de profundidad de solo un centímetro.

Kadambi se une al periódico por su asesor de tesis, Ramesh Raskar, profesor asociado de artes y ciencias de los medios y jefe del grupo Camera Culture.

Toma lenta

Con las imágenes de tiempo de vuelo, se dispara una pequeña ráfaga de luz en una escena, y una cámara mide el tiempo que tarda en regresar, lo que indica la distancia del objeto que lo reflejó. Cuanto más tiempo estalla la luz, más ambigua es la medida de la distancia recorrida. Por lo tanto, la longitud de ráfaga de luz es uno de los factores que determina la resolución del sistema.

El otro factor, sin embargo, es la tasa de detección. Los moduladores, que encienden y apagan un rayo de luz, pueden cambiar mil millones de veces por segundo, pero los detectores de hoy pueden hacer solo unos 100 millones de mediciones por segundo. La tasa de detección es lo que limita los sistemas existentes de tiempo de vuelo a una resolución de escala de un centímetro.

Sin embargo, hay otra técnica de imagen que permite una resolución más alta, dice Kadambi. Esa técnica es la interferometría, en la que un rayo de luz se divide en dos, y la mitad se mantiene en circulación localmente, mientras que la otra mitad, el “rayo de muestra”, se dispara en una escena visual. El haz de muestra reflejado se recombina con la luz localmente circulada, y la diferencia de fase entre los dos haces, la alineación relativa de los valles y crestas de sus ondas electromagnéticas, proporciona una medida muy precisa de la distancia que ha recorrido el haz de muestra.

Pero la interferometría requiere una sincronización cuidadosa de los dos haces de luz. “Nunca se puede poner interferometría en un automóvil porque es muy sensible a las vibraciones”, dice Kadambi. “Estamos utilizando algunas ideas de la interferometría y algunas de las ideas de LIDAR, y estamos realmente combinando las dos aquí”.

Al ritmo

También están, explica, usando algunas ideas de la acústica. Cualquiera que se haya presentado en un conjunto musical está familiarizado con el fenómeno de “golpear”. Si dos cantantes, por ejemplo, están un poco desafinados -uno produce un tono a 440 hertzios y el otro a 437 hertzios- la interacción de sus voces producirá otro tono, cuya frecuencia es la diferencia entre las notas que están cantando, en este caso, 3 hercios.

Lo mismo es cierto con pulsos de luz. Si un sistema de imágenes de tiempo de vuelo enciende luz en una escena a un ritmo de mil millones de pulsos por segundo, y la luz de retorno se combina con un pulso de luz de 999.999.999 veces por segundo, el resultado será una señal luminosa que parpadea una vez por segundo. – una tasa fácilmente detectable con una cámara de video. Y ese lento “latido” contendrá toda la información de fase necesaria para medir la distancia.

Pero en lugar de intentar sincronizar dos señales de luz de alta frecuencia, como deben hacerlo los sistemas de interferometría, Kadambi y Raskar simplemente modulan la señal de retorno, utilizando la misma tecnología que la produjo en primer lugar. Es decir, pulsan la luz ya pulsada. El resultado es el mismo, pero el enfoque es mucho más práctico para los sistemas automotrices.

“La fusión de la coherencia óptica y la coherencia electrónica es muy única”, dice Raskar. “Estamos modulando la luz a unos pocos gigahertz, así que es como encender y apagar una linterna millones de veces por segundo. Pero estamos cambiando eso electrónicamente, no ópticamente. La combinación de los dos es realmente donde obtienes la potencia para este sistema “.

A través de la niebla

Los sistemas ópticos de Gigahertz son naturalmente mejores para compensar la niebla que los sistemas de baja frecuencia. La niebla es problemática para los sistemas de tiempo de vuelo porque dispersa la luz: desvía las señales de luz de retorno para que lleguen tarde y en ángulos extraños. Tratar de aislar una señal verdadera en todo ese ruido es demasiado complicado computacionalmente para hacerlo sobre la marcha.

En los sistemas de baja frecuencia, la dispersión provoca un ligero cambio de fase, que simplemente enturbia la señal que llega al detector. Pero con los sistemas de alta frecuencia, el desplazamiento de fase es mucho mayor en relación con la frecuencia de la señal. Las señales de luz dispersas que llegan a través de diferentes caminos en realidad se cancelarán mutuamente: las depresiones de una onda se alinearán con las crestas de otra. Los análisis teóricos realizados en la Universidad de Wisconsin y en la Universidad de Columbia sugieren que esta cancelación será lo suficientemente amplia como para que la identificación de una verdadera señal sea mucho más fácil.

“Estoy entusiasmado con las aplicaciones médicas de esta técnica”, dice Rajiv Gupta, director del Centro de Ciencias Avanzadas de Imágenes de Rayos X en el Hospital General de Massachusetts y profesor asociado de la Facultad de Medicina de Harvard. “Estaba tan impresionado por el potencial de este trabajo para transformar las imágenes médicas que tomamos el raro paso de reclutar a un estudiante de posgrado directamente a la facultad en nuestro departamento para continuar este trabajo”.

“Creo que es un hito importante en el desarrollo de técnicas de tiempo de vuelo porque elimina el requisito más estricto en el despliegue masivo de cámaras y dispositivos que usan principios de tiempo de vuelo para la luz, es decir, [la necesidad de] una cámara muy rápida “, agrega. “La belleza del trabajo de Achuta y Ramesh es que al crear ritmos entre luces de dos frecuencias diferentes, pueden usar cámaras ordinarias para registrar el tiempo de vuelo”.

Fuente: MIT