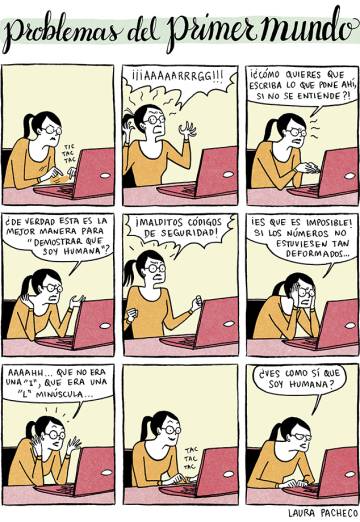

La era de los captcha textuales, esas secuencias de caracteres que los humanos debemos reconocer para demostrar que no somos máquinas, ha llegado a su ocaso. Una reciente investigación, cofinanciada por China y Reino Unido,demuestra que variantes de esta medida de seguridad aún masivamente difundidas en Internet han quedado obsoletas. El estudio presenta un sistema de inteligencia artificial capaz de atacar algunas de las webs más populares del mundo, como Wikipedia, Microsoft o eBay, gracias a la habilidad de poder resolver fácilmente los captcha de texto que utilizan muchas de ellas. Los autores plantean la necesidad de rediseñar estas pruebas y desarrollar sistemas más idóneos y modernizados para evitar ataques de hackers y bots a las webs.

Ya han pasado casi 20 años desde que cuatro investigadores instalados en EE UU empezaron a preocuparse por cómo diferenciar entre seres humanos y máquinas a la hora de garantizar la seguridad de las webs. Así fue cómo llegaron a desarrollar y difundir los primeros sistemas captcha (acrónimo de una expresión inglés que significa “test de Turing completamente automático y público para diferenciar ordenadores de humanos”). En los años siguientes, ha sido toda una carrera entre intentos de desarrollo de ciberataques capaces de sortearlas sin habilidades humanas y evolución de contramedidas necesarias para incrementar su eficacia. Los captcha todavía son largamente utilizados, pero les cuesta aguantar el ritmo de crecimiento incesante de la inteligencia artificial.

Muchos sistemas de reconocimiento artificial de los captcha funcionan a partir de pruebas reales ya resueltas por humanos. “Los sistemas de ataque anteriores requerían que se recogieran y etiquetaran previamente millones de captcha”, explica Zheng Wang, investigador de la Universidad de Lancaster (Reino Unido) y coautor del estudio. En cambio, el tipo de ataque que proponen él y sus compañeros aprovecha de los últimos avances de las técnica de machine learning para reducir la necesidad de intervención humana, según mantienen. “Nuestro ataque tan solo necesita 500 captcharesueltos humanamente”, asegura Wang.

Para conseguirlo, su modelo se basa en un sistema llamado Generative Adversarial Network (GAN), dotado tanto de una red de creación de ejemplos artificiales como de una capaz de distinguir entre estos y los ejemplos reales. Aplicada a los captcha, esta arquitectura puede generar rápidamente copias de las secuencias textuales reales, comparar los dos tipos, afinar la fidelidad de las copias hasta que ya no se puedan distinguir de los originales, eliminar los elementos de distorsión utilizados para impedir a las máquinas el reconocimiento de los caracteres (como sobreposiciones, líneas oclusivas o letras y números más amplios o huecos) y entrenarse para aprender a resolver con una precisión cada vez más alta las nuevas secuencias detectadas.

El hecho de no necesitar una base amplia de captcha resueltos por humanos es un factor de eficacia clave, aseguran los autores. “Si consideramos que a un humano reconocer un captcha le va a llevar unos 30 segundos, calculamos que los ataques desarrollados anteriormente necesitarían de unos 12 meses de trabajo para recoger todos los datos previos, mientras que el nuestro solo requiere unas cuatro horas”, asegura Wang. Este inmenso ahorro de tiempo logrado por la inteligencia artificial permite romper estas barreras de manera “barata”, agrega.

Porcentajes de éxito

En el estudio, él y sus compañeros prueban la eficacia del sistema en 33 esquemas de captcha textuales. De ellos, 11 se utilizan en 32 de las 50 webs más populares del mundo según el ranking de abril 2018 de Alexa.com, filial de Amazon especializada en estadísticas sobre tráfico en Internet. Entre las páginas consideradas, están webs como Wikipedia, Microsoft, Google, la plataforma de pagos online china Alipay o Baidu, el principal buscador del país asiático.

El porcentaje de éxito en la resolución de los captcha puede superar el 85%, como en el caso de eBay, o alcanzar casi un 70%, como ocurre con Microsoft. Entre los sistemas de defensa más seguros, en cambio, se encuentran los de Baidu (6% de éxito) y Google (3%). En todos estos ejemplos, el tiempo de resolución de un CAPTCHA es de pocos milisegundos. Para la mayoría de los esquemas analizados, este método resulta mucho más eficaz que ataques propuestos anteriormente (por ejemplo, resuelve un 78% de las secuencias de seguridad de Wikipedia, mientras que los modelos anteriores no llegaban a un 30%).

“Mostramos, de hecho, que todos los esquemas basados en captcha textuales utilizados por las páginas webs más visitadas son vulnerables a nuestro ataque”, concluye Wang. “Esto ocurre porque somos capaces de romper los esquemas que utilizan”, agrega. El resultado final es una invitación a plantearse alternativas de seguridad para seguir protegiéndolas de la exposición a ciberataques. “Nuestro trabajo sugiere que la primera barrera de defensa de muchas páginas web ya no es fiable”, mantiene Wang.

Entender las amenazas y buscar nuevas barreras

La amenaza principal debida a la ineficacia de los captcha es que “los cibercriminales utilicen los servicios ofrecidos por una web de forma automática”, sostiene Guillermo Suarez-Tangil, del King’s College de Londres. Uno de los ejemplos más comunes, según mantiene, es la difusión viral por parte de bots de bulos en distintas redes sociales. Otro posible riesgo es que los atacantes consigan acceder a cuentas de correos ya existentes para así enviar masivamente spam. “Superar estos mecanismos de seguridad también podría permitir a los adversarios robar datos personales o hasta falsificar identidades”, agrega por su parte Wang.

En la red, explica Suarez-Tangil, “los atacantes parten de la ventaja de necesitar tener éxito solo una única vez para poder atacar un sistema”. Por el otro lado, “los sistemas de defensa tienen que estar preparados para bloquear todo tipo de ataques. Basta con que fallen una vez, para que el resto de medidas de seguridad sean inútiles, por muy avanzadas que sean”, contrasta. Por eso, asegura que trabajos como este permiten evidenciar a qué riesgos estamos expuestos. “Por cada artículo que describe un problema, salen varios más que proponen contramedidas”, agrega.

PRUEBAS MÁS COMPLEJAS PARA NEUTRALIZAR A LOS ‘HACKERS’

Guillermo Suárez-Tangil, del King’s College of London, recuerda que no existen solo captchas de tipo textual, sino también otros “más difíciles de romper, como los basados en vídeos, en conceptos más abstractos o en confianza”. Entre estos ejemplos, detalla, están las últimas versiones de recaptcha, desarrolladas por Google, que indican cómo de fiable es una conexión. “A conexiones menos fiables se les reta con pruebas más complejas”, explica.

Otra medida útil para incrementar la seguridad de una web, en su opinión, es “habilitar sistemas de verificación de dos pasos”. También asegura que el coste para desarrollar un sistema anticaptcha vale más dinero que mejorar los servicios ofrecidos por plataformas como recaptcha, que además suelen ser gratuitos.

En el estudio que Zheng Wang firma como coautor, financiado por entidades científicas públicas dependientes de los Gobiernos de China y Reino Unido y por la asociación científica británica Royal Society, se asegura que el sistema de ataque mostrado podría extenderse con facilidad a captchas textuales con número de caracteres variable o de dos o más palabras y, con un ulterior desarrollo de su arquitectura, también a los de imágenes o vídeos.

Aunque alerta de que para muchas páginas desarrollar un sistema de defensa más potente podría no ser “un problema banal”, Wang considera que una medida alternativa posible es la de crear mecanismos que se basan en factores múltiples, como información biométrica o la localización de los dispositivos y los horarios de conexión. Datos de este tipo podrían permitir bloquear intentos de acceso con la clave de un usuario desde ubicaciones y en franjas horarias sospechosas, pone como ejemplo.

Fuente: El Pais