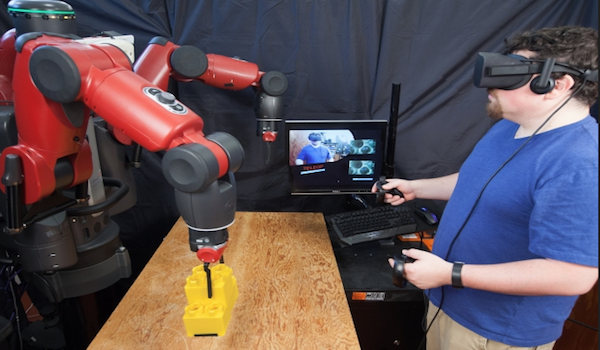

Consistiendo en un auricular y controladores manuales, el nuevo sistema VR de CSAIL permite a los usuarios teleoperar un robot utilizando un auricular Oculus Rift. Un sistema de realidad virtual del Laboratorio de Informática e Inteligencia Artificial podría facilitar a los trabajadores de fábrica el teletrabajo.

Ciertas industrias tradicionalmente no han tenido el lujo de teletrabajo. Muchos trabajos de manufactura, por ejemplo, requieren una presencia física para operar maquinaria.

Pero, ¿qué sucedería si esos trabajos pudieran hacerse a distancia? La semana pasada los investigadores del Laboratorio de Informática e Inteligencia Artificial del MIT ( CSAIL ) presentaron un sistema de realidad virtual (VR) que le permite teleoperar un robot usando un auricular Oculus Rift.

El sistema incrusta al usuario en una sala de control VR con múltiples pantallas de sensores, haciéndolo sentir como si estuvieran dentro de la cabeza del robot. Mediante el uso de controladores manuales, los usuarios pueden combinar sus movimientos con los movimientos del robot para completar varias tareas.

“Un sistema como este podría ayudar a los humanos a supervisar robots a distancia”, dice el postdoctor de la CSAIL, Jeffrey Lipton, quien fue el autor principal en un artículo relacionado sobre el sistema. “Al teleoperar robots desde casa, los obreros podían tele-conmutar y beneficiarse de la revolución de TI, tal como lo hacen ahora los trabajadores de cuello blanco”.

Los investigadores incluso se imaginan que un sistema de este tipo podría ayudar a emplear un número cada vez mayor de videojuegos sin empleo al “gameificar” posiciones de fabricación.

El equipo utilizó el robot humanoide Baxter de Rethink Robotics, pero dijo que puede trabajar en otras plataformas de robots y también es compatible con los auriculares HTC Vive.

Lipton co-escribió el artículo con la directora de la CSAIL Daniela Rus y la investigadora Aidan Fay. Presentaron el documento en la reciente Conferencia Internacional IEEE / RSJ sobre Robots y Sistemas Inteligentes en Vancouver.

Tradicionalmente, ha habido dos enfoques principales para el uso de VR para la teleoperación.

En un modelo directo, la visión del usuario está directamente acoplada al estado del robot. Con estos sistemas, una señal retardada podría conducir a náuseas y dolores de cabeza, y el punto de vista del usuario se limita a una perspectiva.

En un modelo ciber-físico, el usuario está separado del robot. El usuario interactúa con una copia virtual del robot y del entorno. Esto requiere mucho más datos, y espacios especializados.

El sistema del equipo CSAIL está a medio camino entre estos dos métodos. Resuelve el problema de retardo, ya que el usuario está constantemente recibiendo retroalimentación visual desde el mundo virtual. También resuelve la cuestión cibernética de ser distinto del robot: Una vez que un usuario pone el auricular y se conecta al sistema, se sentirá como si estuviera dentro de la cabeza de Baxter.

El sistema imita el modelo homúnculo de la mente: la idea de que hay un pequeño humano dentro de nuestro cerebro controlando nuestras acciones, viendo las imágenes que vemos y comprendiéndolas para nosotros. Si bien es una idea peculiar para los seres humanos, para los robots que encaja: Dentro del robot es un humano en una sala de control virtual, ver a través de sus ojos y el control de sus acciones.

Usando los controladores de Oculus, los usuarios pueden interactuar con los controles que aparecen en el espacio virtual para abrir y cerrar las pinzas de mano para recoger, mover y recuperar elementos. Un usuario puede planificar movimientos basados en la distancia entre el marcador de posición del brazo y su mano mientras mira la pantalla en vivo del brazo.

Para que estos movimientos sean posibles, el espacio humano se asigna al espacio virtual, y el espacio virtual se asigna al espacio del robot para proporcionar una sensación de co-localización.

El sistema también es más flexible en comparación con los sistemas anteriores que requieren muchos recursos. Otros sistemas pueden extraer información bidimensional de cada cámara, crear un modelo 3D completo del entorno y luego procesar y volver a mostrar los datos. Por el contrario, el enfoque del equipo CSAIL pasa por alto todo eso simplemente tomando las imágenes 2-D que se muestran a cada ojo. (El cerebro humano hace el resto al inferir automáticamente la información tridimensional.)

Para probar el sistema, el equipo primero teleoperó a Baxter para hacer tareas sencillas como recoger tornillos o cables de grapado. Luego, los usuarios de prueba teleoperaron al robot para recoger y apilar bloques.

Los usuarios completaron con éxito las tareas a una tasa mucho más alta en comparación con el modelo directo. Como era de esperar, los usuarios con experiencia en juegos tenían mucha más facilidad con el sistema.

Probado contra los sistemas actuales de última generación, el sistema de CSAIL era mejor en agarrar objetos el 95 por ciento del tiempo y 57 por ciento más rápido en hacer tareas. El equipo también mostró que el sistema podría pilotar al robot desde cientos de millas de distancia; las pruebas incluyeron el control de Baxter en el MIT de la red inalámbrica de un hotel en Washington.

“Esta contribución representa un hito importante en el esfuerzo de conectar al usuario con el espacio del robot de una manera intuitiva, natural y efectiva”. dice Oussama Khatib, un profesor de ciencias de la computación en la Universidad de Stanford que no participó en el documento.

El equipo finalmente quiere centrarse en hacer el sistema más escalable, con muchos usuarios y diferentes tipos de robots que pueden ser compatibles con las tecnologías de automatización actuales.

El proyecto fue financiado, en parte, por la Boeing Company y la National Science Foundation.

Fuente: MIT