Un nuevo algoritmo permite detectar ruidos y sonidos, representando sus variaciones en el tiempo en forma de videos. Simplifica el trabajo de los especialistas para diseñar productos y dispositivos más silenciosos, desde aviones hasta lavavajillas.

El estudio de los mapas de ruido que permiten disminuir el impacto sonoro de toda clase de diseños industriales será ahora más sencillo, gracias a un nuevo algoritmo de imagen creado por científicos de la Universidad de Sherbrooke, en Canadá. La innovación hace posible “leer” las variaciones sonoras y transformarlas en videos, una opción más funcional que los gráficos que se emplean actualmente.

De acuerdo a una nota de prensa, los especialistas destacan que esta posibilidad de “ver” los sonidos a través de videos simplifica enormemente el estudio sonoro de un área o sector, un trabajo que habitualmente llevan adelante los expertos en acústica para evaluar las diferentes fuentes de ruido y sus magnitudes.

Esta tarea, vital para desarrollar productos más silenciosos, como por ejemplo en el caso del diseño de electrodomésticos, se realiza actualmente a través de gráficos que representan las frecuencias sonoras. Se trata de imágenes similares a las que se pueden apreciar al utilizar cualquier tipo de editor de sonido para un ordenador hogareño.

Con el nuevo sistema, los acústicos tendrán la alternativa de sacar una “foto sonora” del lugar estudiado prácticamente al instante. El propósito de estas investigaciones es reducir el ruido y mejorar el confort acústico, tanto de productos y dispositivos como de espacios en los que se deben desarrollar actividades específicas que requieren estas condiciones.

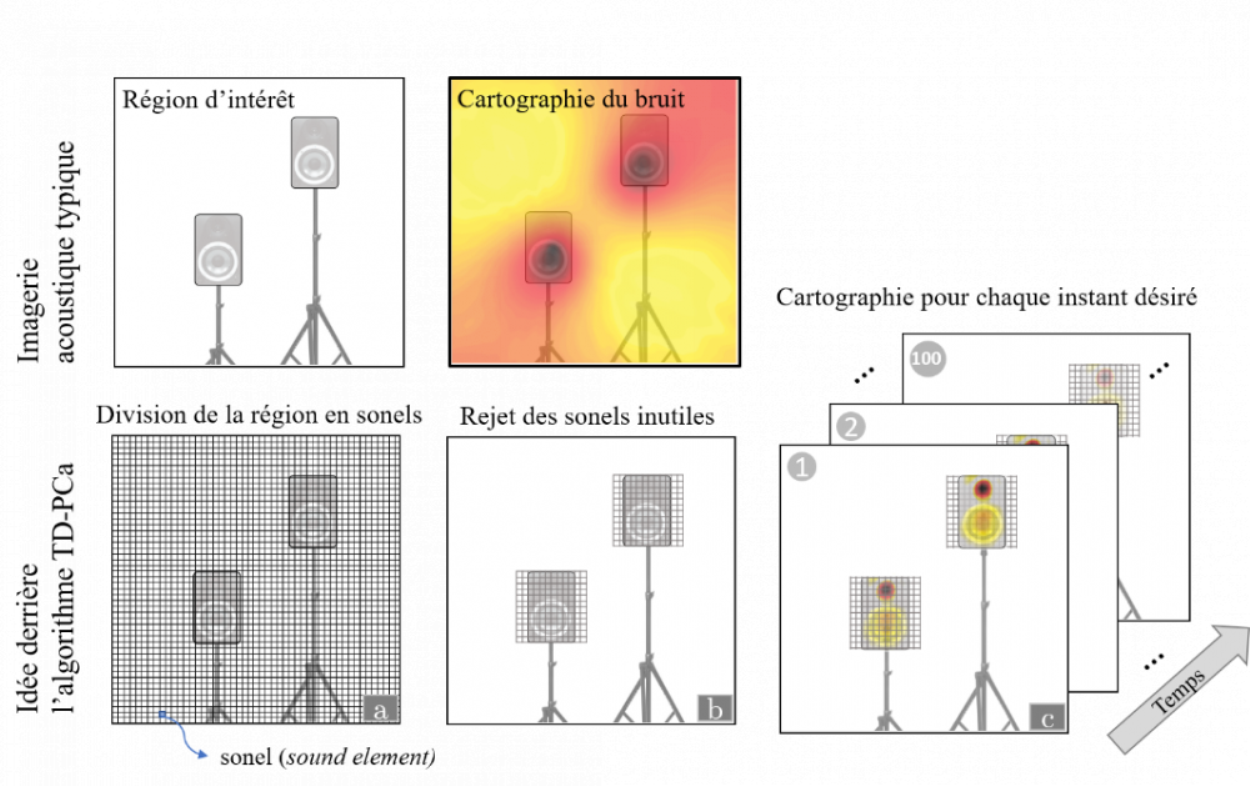

Imagen acústica obtenida y explicación del algoritmo. Foto: Universidad de Sherbrooke.

Imagen acústica obtenida y explicación del algoritmo. Foto: Universidad de Sherbrooke.

Simplificación del proceso

De la misma forma que los profesionales de la salud obtienen imágenes del interior de nuestro cuerpo para tratar diferentes patologías o realizar controles, como en el caso de una ecografía o una resonancia magnética, los especialistas en acústica ahora también podrán visualizar algo que para nosotros es invisible: el sonido.

Otros algoritmos utilizados actualmente para intentar hacer visible el sonido tenían la desventaja de proponer estructuras técnicas poco prácticas. Se necesitaba una gran cantidad de micrófonos desperdigados por todo el sector a analizar, con el objetivo de captar al detalle las frecuencias y variaciones de los sonidos.

El nuevo algoritmo desarrollado por los científicos canadienses, que se denomina TD-PCa, presenta el beneficio de poder captar las variaciones del ruido a lo largo del tiempo de una forma mucho más sencilla. En primer término, divide el área de interés a estudiar en varios miles de fuentes elementales de ruido, llamadas sonels.

El propósito del algoritmo es determinar la magnitud y características de cada una de esas fuentes de ruido o sonels, pero el trabajo puede ser realmente muy complejo frente a la cantidad de datos a analizar. Para simplificarlo, el nuevo algoritmo emplea un método estadístico que identifica los sonels con mayor trascendencia en cada caso.

Visualización de fenómenos físicos no observables

Gracias a esto, se reduce el número de sonels a considerar en la ecuación en un 99%. De esta forma, el algoritmo resuelve el problema con rapidez y con tanta sencillez que las operaciones se podrían realizar en un ordenador portátil de bajas prestaciones. Además, este esquema permite disminuir considerablemente el número de micrófonos necesarios para los estudios sonoros.

En resumen, TD-PCa facilita la visualización de fenómenos físicos no observables como los sonidos, utilizando algoritmos de imagen tradicionales, con un esquema técnico simple que hasta podría adaptarse en un futuro para su uso en tablets, smartphones y otros dispositivos masivos.

Con este avance, los acústicos podrán identificar mejor las fuentes de ruido y colaborar en el diseño de productos cada vez más silenciosos.

Fuente:

Time domain imaging of extended transient noise sources using phase coherence. Maxime Bilodeau, Nicolas Quaegebeur, Olivier Robin, Patrick O’Donoughue, Patrice Masson and Alain Berry. The Journal of the Acoustical Society of America (2019).DOI:https://doi.org/10.1121/1.5138926