A estas alturas, creo que no hay nadie que dude de que la inteligencia artificial es una tecnología que tiene mucho futuro. De unos años a esta parte, no hay ninguna gran compañía que no la utilice en alguno de sus productos o soluciones, ya que se ha demostrado que es la mejor para realizar tareas muy concretas de manera mucho más eficiente que el ser humano, como por ejemplo ocurre cuando se quieren identificar imágenes o extraer información que aparece en millones de fotografías y vídeos en cuestión de horas. También está resultando un excelente rival y un campeón insuperable en juegos de estrategia como el ajedrez, el asiático GO, o videojuegos del género ETR (estrategia en tiempo real) como es el mítico Starcraft II.

20 años más tarde se acuña oficialmente el término Inteligencia Artificial y se pronostica su poder transformador del mundo tal y como se conocía en la siguiente década. Pero como diría un informático, fue un spoiler alert y nada ocurrió como estaba previsto, lo que originó unas expectativas que no eran viables técnicamente y que llevaron al invierno de la inteligencia artificial, ocasionando una gran cantidad de literatura de ciencia ficción y haciendo que la IA pasará de ser un gran fenómeno para considerarse un gran bluf.

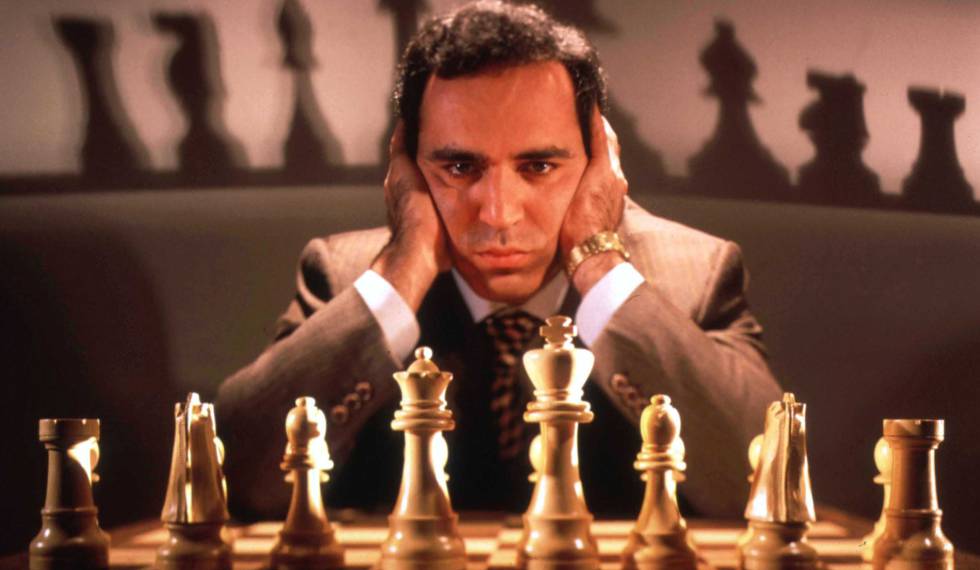

A pesar de todo, se siguió avanzando y en el 2000 ya se utilizaban todo tipo de algoritmos para que las máquinas realizaran tareas básicas y no tan básicas según las reglas de si se cumple esto, haz esto otro. Y algunas de ellas, como por ejemplo el superordenador Deep Blue, que ayudó a ganar al campeón mundial Kasparov en aquella histórica partida de ajedrez, incluyeron árboles de decisiones para seleccionar el mejor movimiento en función de las probabilidades de éxito, no sólo del siguiente movimiento, sino de todos los siguientes.

La creación de este tipo de máquinas era lento y costoso, por lo que pronto se desarrolló la rama del machine learning, que utilizaba patrones previamente adquiridos para crear estos modelos en lugar de hacerlo el ser humano. El tipo de ML más utilizado en la actualidad es el conocido como deep learning, que apareció por primera vez ese mismo año y que simula el funcionamiento de las redes neuronales del cerebro humano.

Lamentablemente, entrenar en base a ejemplos, fotos y vídeos es una tarea computacionalmente costosa y en 2012 se produjo el fin de la Ley de Moore (ley que determinaba que aproximadamente cada 2 años se tenía que duplicar el número de transistores en un microprocesador para no minimizar su capacidad). Para que los procesadores o unidades de centrales de procesamiento (CPU) pudieran seguir creciendo al ritmo que necesitaba el deep learning y sus casos de uso, era necesario algo más. Y ese algo más vino de la mano de la unidad de procesamiento gráfico o tarjeta gráfica (GPU) que la industria del videojuego llevaba años desarrollando para procesar grandes volúmenes de datos y desplegar imágenes fotorrealistas en tiempo real.

La GPU está pensada para poder ofrecer el mayor ancho de banda posible, mientras que la CPU proporciona las respuestas en el menor tiempo posible. O explicado de otra forma: si tuviéramos que llevar paquetes de un sitio a otro, la CPU sería un deportivo capaz de llevarlos a una gran velocidad, pero al tener un maletero muy reducido (con poca memoria), sólo podría llevar pocos a la vez. Y la GPU sería como un camión, que puede llevar muchos paquetes a la vez, aunque más lentamente.

La potencia de cálculo de la GPU es la responsable de que se procese la cantidad ingente de información que todos producimos y que ha dado lugar a que vivamos la época dorada del dato, lo que ha provocado que haya renacido el interés por la inteligencia artificial.

Esta nueva situación también ha traído otros elementos que hacen que la IA sea mucho más accesible a las empresas, como el cloud computing. Aquellas compañías que no cuenten con suficientes datos o personal especializado con capacidad para implementar algoritmos pueden usar las GPUs que están disponibles en la modalidad de pago por uso.

Así cada nube permite que utilices la IA adaptándola a las necesidades de cada uno, ya sea para el reconocimiento de objetos, la voz, o estimación de ventas a futuro, entre otros. Y aunque todavía quede mucho para ver en acción lo que ya vemos en las películas, lo cierto es que la IA ya es una tecnología de la que no podemos prescindir.

Fuente: Retina El Pais